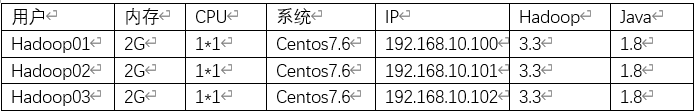

配置

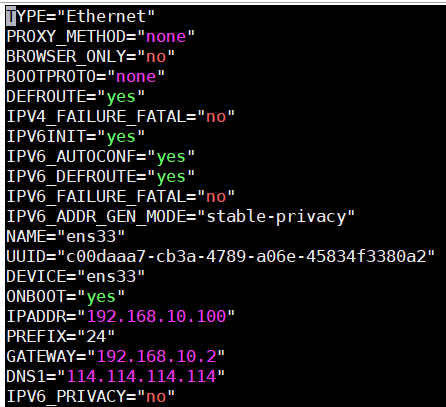

网卡信息

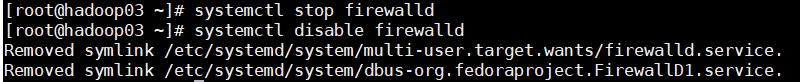

关闭防火墙

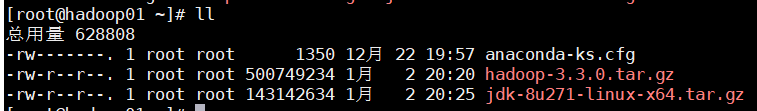

上传hadoop和jdk安装包(直接传到root 目录,建什么文件夹,麻烦)

一、主机基础配置

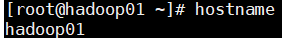

1、更改主机名

hostnamectl set-hostname hadoop01

更改完成后hostname查看

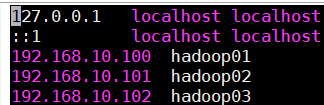

2、更改hosts,修改主机名与主机映射关系(三台配置一样)

vi /etc/hosts

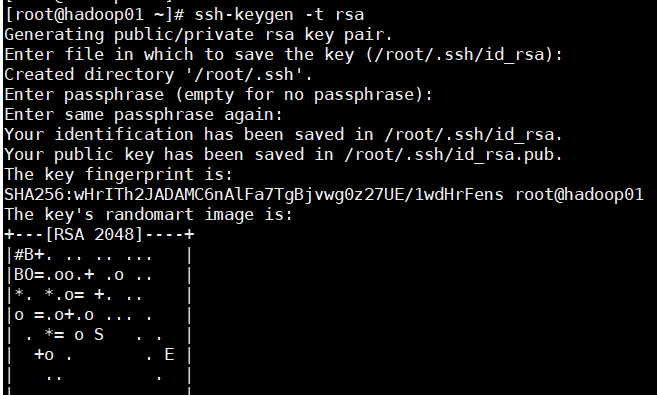

3、配置免密登录

生成秘钥

一路回车生成秘钥,三台都要

ssh-keygen -t rsa

使用命令复制到各个公钥文件中(每个主机都要执行)

//yes完了之后输入密码

ssh-copy-id -i hadoop01

ssh-copy-id -i hadoop02

ssh-copy-id -i hadoop03

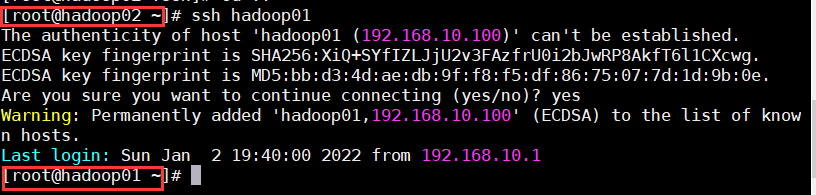

验证免密钥登陆(三台都要测)

ssh hadoop01 (01-03)

exit

4、配置JDK

解压JDK安装包

tar -xvf jdk-8u271-linux-x64.tar.gz

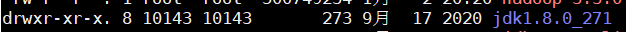

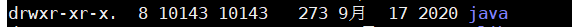

移动jdk1.8.0_271到usr目录并重命名为java

mv jdk1.8.0_271/ /usr/java

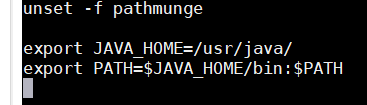

配置java环境变量

vi /etc/profile

在最后一行加上

export JAVA_HOME=/usr/java/

export PATH=$JAVA_HOME/bin:$PATH

使配置生效

source /etc/profile

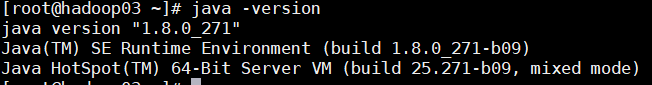

查看java版本

java-version

到此,基础配置完成

二、hadoop安装

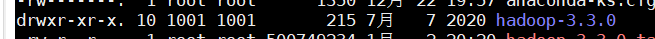

解压hadoop安装包

tar xvf hadoop-3.3.0.tar.gz

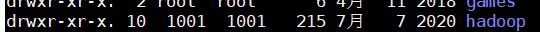

移动hadoop-3.3.0到usr目录并重命名为hadoop

mv hadoop-3.3.0 /usr/Hadoop

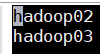

1、配置workers

cd /usr/hadoop/etc/hadoop/

vi workers

填入以下内容

hadoop01

hadoop02

2、配置hadoop配置文件

cd /usr/hadoop/etc/hadoop

配置核心组件core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop01:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/hadoop/tmp/data</value>

</property>

</configuration>配置文件系统hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.http-address</name>

<value>hadoop01:9810</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop01:9090</value>

</property>

</configuration>配置文件系统yarn-site.xml

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop01</value>

</property>

</configuration>配置计算框架 mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>3、配置hadoop环境变量

cd /usr/hadoop/etc/hadoop/

配置环境变量hadoop-env.sh

填入以下内容

export JAVA_HOME=/usr/java

4、配置启动脚本

cd /usr/hadoop/sbin/

修改start-dfs.sh,stop-dfs.sh

增加以下内容

HDFS_DATANODE_USER=root

HDFS_DATANODE_SECURE_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root修改start-yarn.sh,stop-yarn.sh

增加以下内容

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root5、启动hadoop

配置环境

vi /etc/profile

export HADOOP_HOME=/usr/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

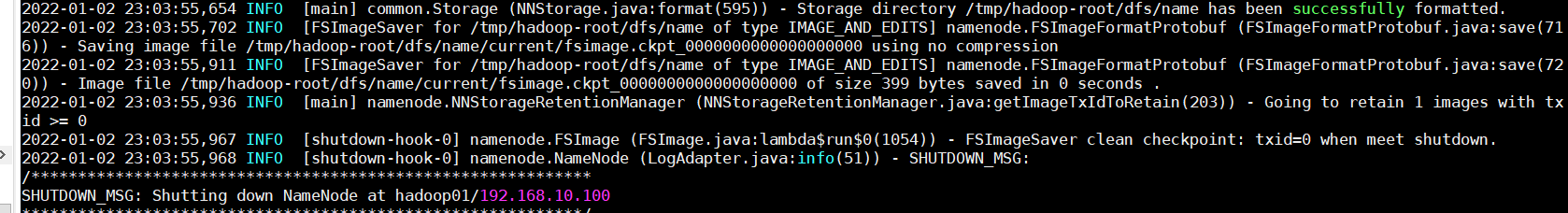

首次启动需要格式化HDFS

hdfs namenode -format

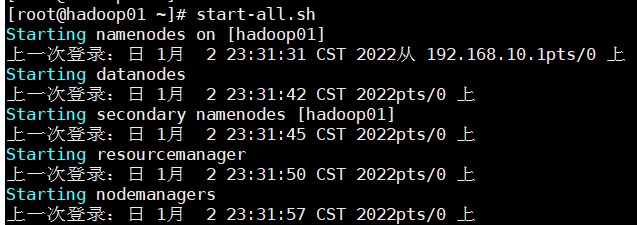

启动

进入/usr/hadoop/sbin目录

./start-all.sh

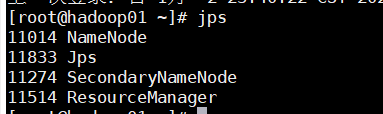

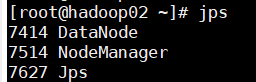

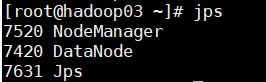

输入jps查看节点

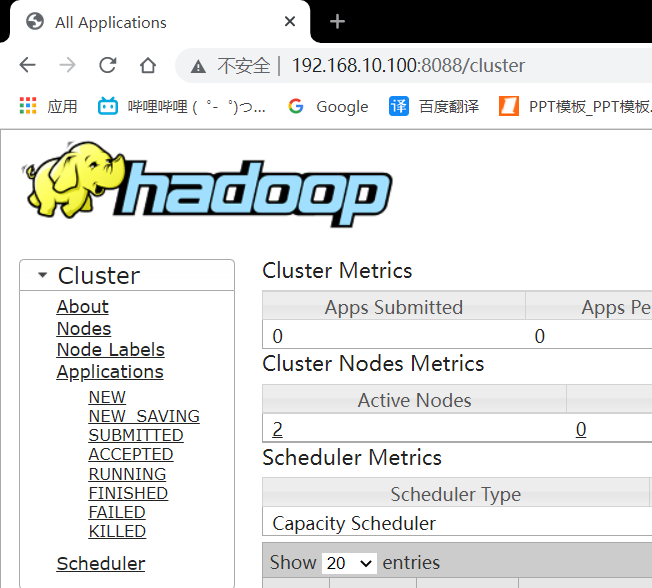

网页访问

http://192.168.10.100:8088/

评论区: